感谢Cocos团队开发出跨平台的数据统计平台,并且还免费使用,开心~,但是使用过程中有几个不懂的问题,希望有明白的小伙伴能够给解答一下:

-

init接口中的 appSecret 和 callnumber 具体是什么含义,在文档中没有找到相关介绍

-

实时数据的刷新间隔是多少?目前感觉得有30分钟才会刷新一次数据

-

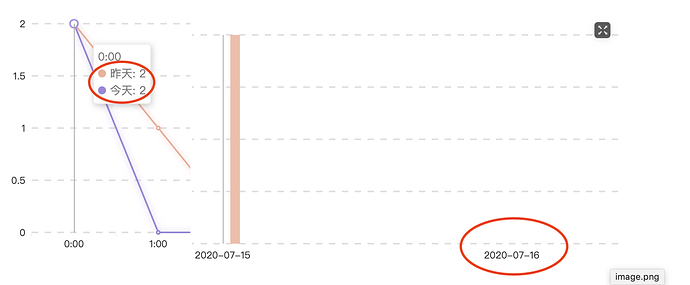

活跃设备中记录到了昨天16日的活跃设备数量,但是在玩家信息概览中并没有16日到数据

-

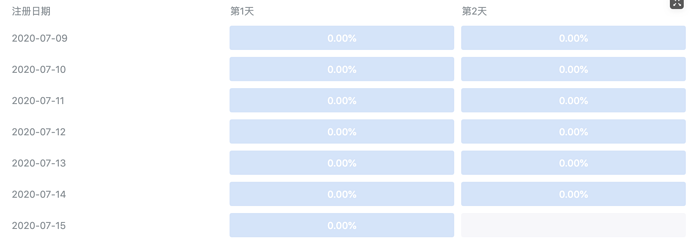

留存界面,第一天是指次日留存么?当前是17号,看不到15 -> 16日到留存信息

-

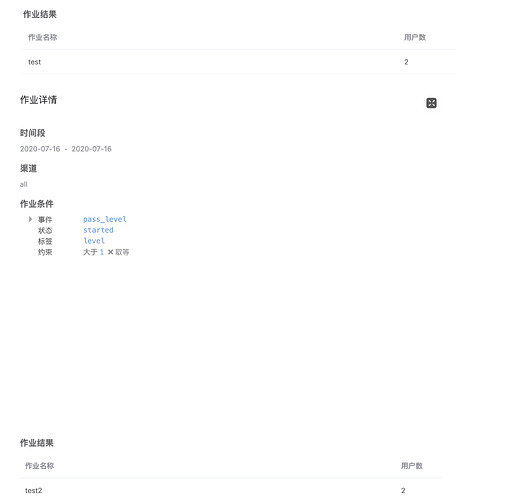

16日设置新增到事件,并且已经发送了相关到事件信息,看到日志有正常返回。 在埋点分析中通过”作业“方式也可以查到16日到事件信息,但是在漏斗信息中16日到漏洞事件并没有具体数据产生。而且在详细事件中也没有任何事件数据。 (16日测试时,并没有调用login_success)

-

任何事件的触发,是否都要基于先触发了login_success之后才会有统计?

-

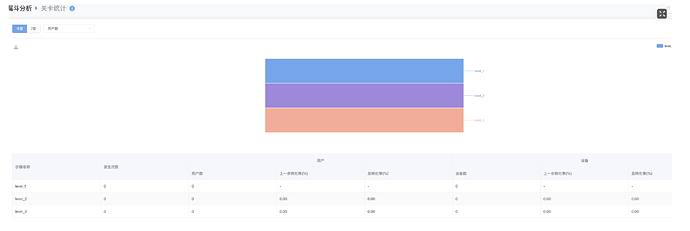

当前的后台工具,是否能支持查看具体每一关的转化比例(因为目前小游戏大多是以推关卡形式的,能够具体观察到某一关到流失比例,对调产品很重要),当前的这个后台好像并不能很直观的看到。如果是使用漏斗到方式,如果关卡有100关甚至更多,应该不支持吧。

-

建议:是否可以开放一个测试模式,数据能够比较即时到响应,哪怕只可以绑定一个设备也可以。现在想测试一下数据上传统计,要等一整天才能看到数据,如果发现有问题,还要再继续等下一天。