一个3M的xlsx表打成json后达到4M

这个时候我有必要去换方式吗?

因为json的格式基本都是一个key对应一个value

我现在换成一个xlsx生成一个bin二进制文件

现在大小是1.4M

这种方式是否可行,我看cocos打包哪里也有压缩的,不知道我这种做法是不是多此一举

打成二进制,如果不是有特殊格式优化以及相应的运行时解析,二进制感觉还是负优化

你可以试试将json进行去空格去换行压缩,在加上gzip估计就和1.4m差不多,甚至还要好

这边都是一个key对应一个value,还是压缩过的,表一大起来太多无用的key了,我试过单key对多value的,这种是2M左右

大佬,如果所有表整合起来有13M还是压缩过的你说要优化吗

去空格去压缩,json分割。游戏再合并

比如对于

{

“1”: {

“id”: “1”,

“name”: 1,

“data”: {}

}

“2”: {

“id”: “2”,

“name”: 2,

“data”: {}

}

}

改成格式:

{

“key”: [“id”, “name”, “data”],

“value”: [

[“1”, 1, {

“a”: null

}],

[“2”, 2, {

“b”: null

}]

]

}

这样会变大吗?

二进制的话估计就几百k,是时候推推这个免费的工具了: go-xlsx-exporter/doc/cocoscreator.md at main · wingcd/go-xlsx-exporter (github.com)

这种小很多,但还是没有二进制小

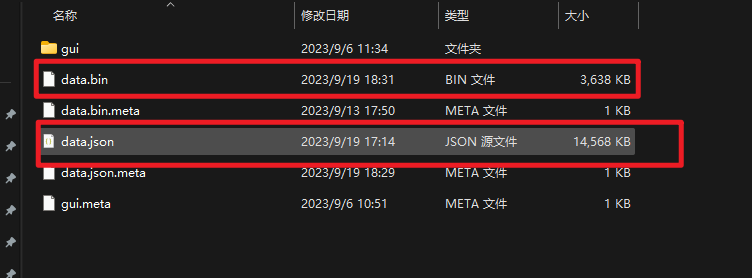

我现在弄成一个bin文件了

同一套xlsx生成的大小

不用了,我自己也弄了一套

你先优化 然后在转成二进制 不就更小了吗

我这个二进制是 单key对多value的方式的