看到有人用ollama实现unity调用本地的llm

还unity,调用大模型你可以直接http,或者jni也行

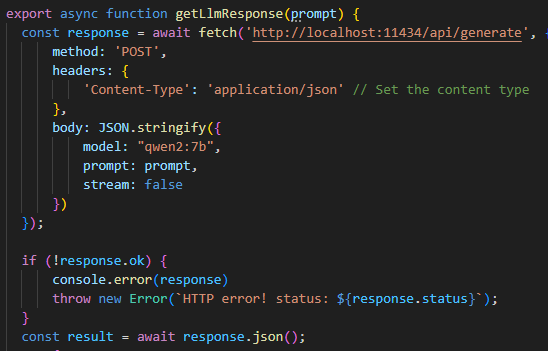

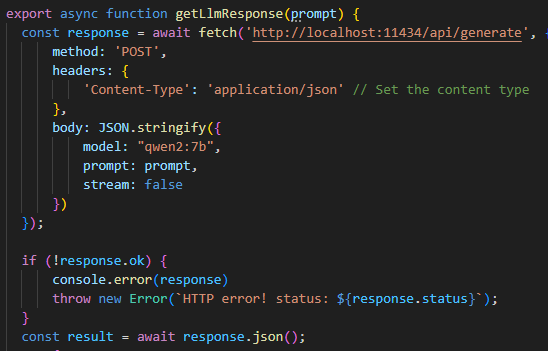

关键词>js调用本地大模型

用http调用是可以,但是异步返回不知道为啥也太慢了

可能因为http 正常的post要等结果生成完了才返回,你用event-stream、fetchEventSource

1赞

用流式传输 不需要等.

看到有人用ollama实现unity调用本地的llm

还unity,调用大模型你可以直接http,或者jni也行

关键词>js调用本地大模型

用http调用是可以,但是异步返回不知道为啥也太慢了

可能因为http 正常的post要等结果生成完了才返回,你用event-stream、fetchEventSource

用流式传输 不需要等.