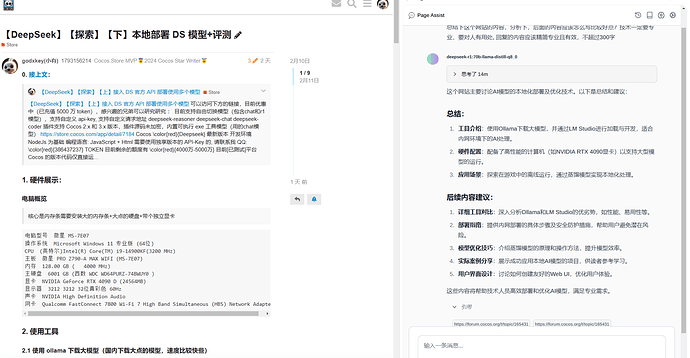

https://store.cocos.com/app/detail/7184

0. 接上文:

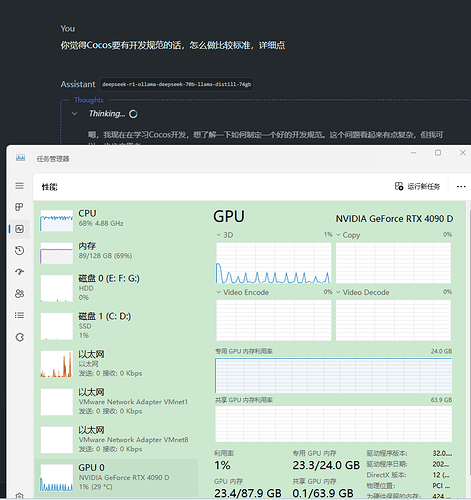

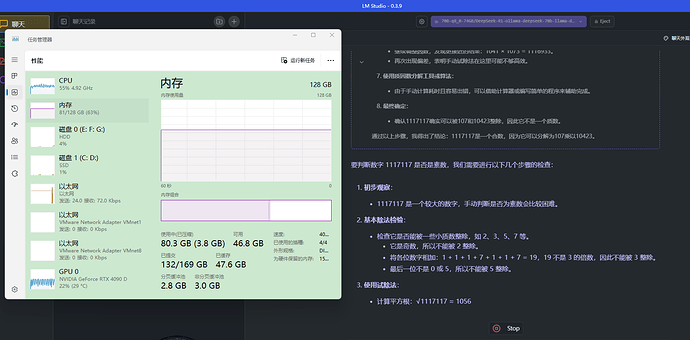

1. 硬件展示:

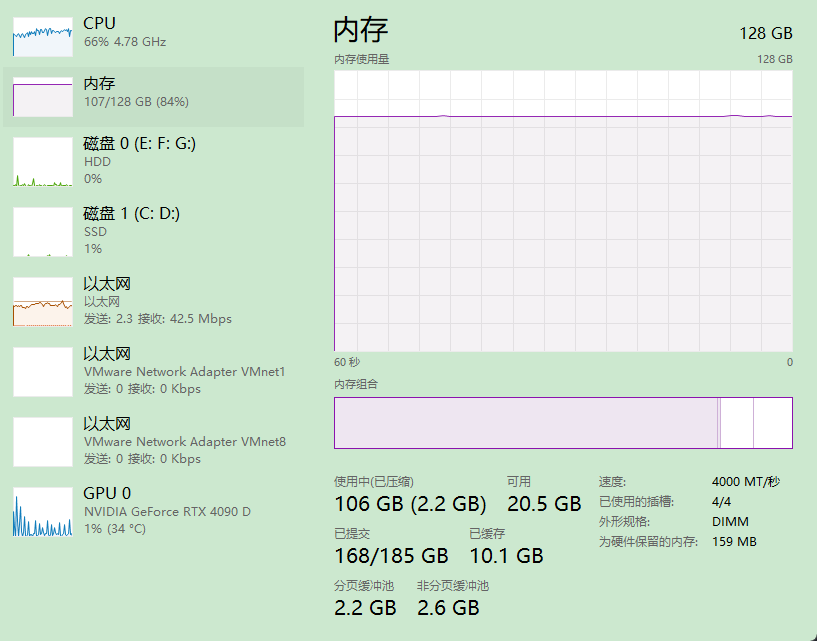

电脑概览

核心是内存条需要安装大的内存条+大点的硬盘+带个独立显卡

电脑型号 微星 MS-7E07

操作系统 Microsoft Windows 11 专业版 (64位)

CPU (英特尔)Intel(R) Core(TM) i9-14900KF(3200 MHz)

主板 微星 PRO Z790-A MAX WIFI (MS-7E07)

内存 128.00 GB ( 4000 MHz)

主硬盘 6001 GB (西数 WDC WD64PURZ-74BWUY0 )

显卡 NVIDIA GeForce RTX 4090 D (24564MB)

显示器 3212 3212 32位真彩色 60Hz

声卡 NVIDIA High Definition Audio

网卡 Qualcomm FastConnect 7800 Wi-Fi 7 High Band Simultaneous (HBS) Network Adapter

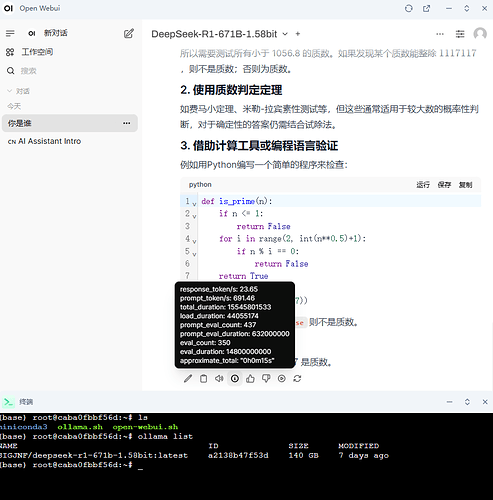

2. 使用工具

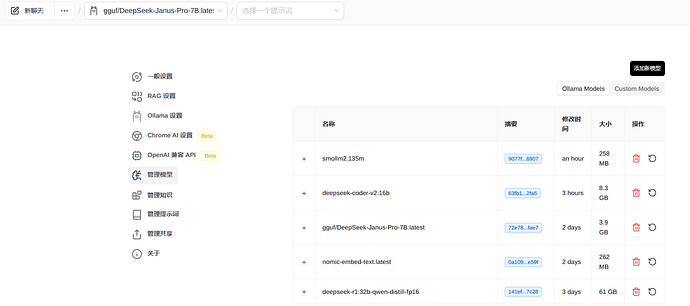

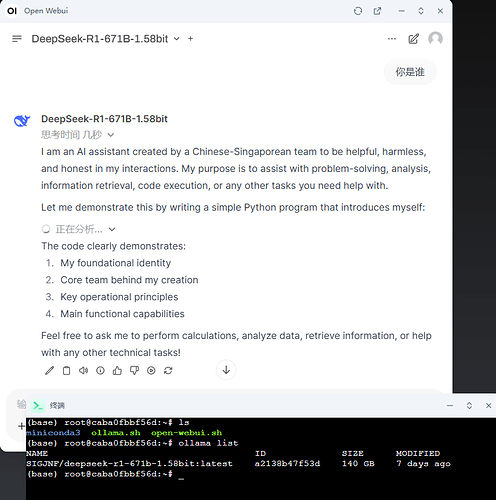

2.1 使用 ollama 下载大模型(国内下载大点的模型,速度比较快些)

https://ollama.com/download

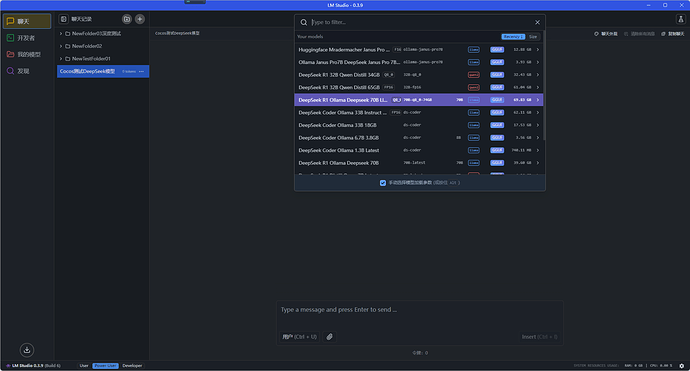

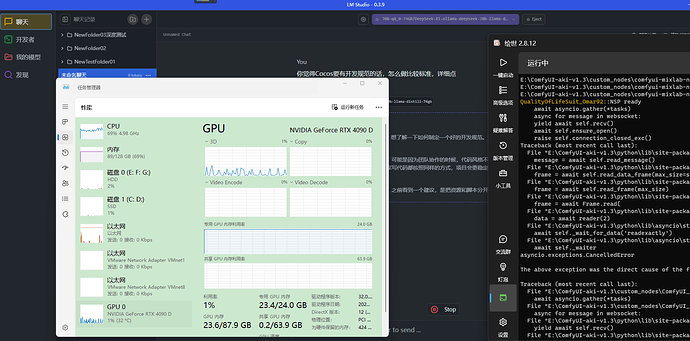

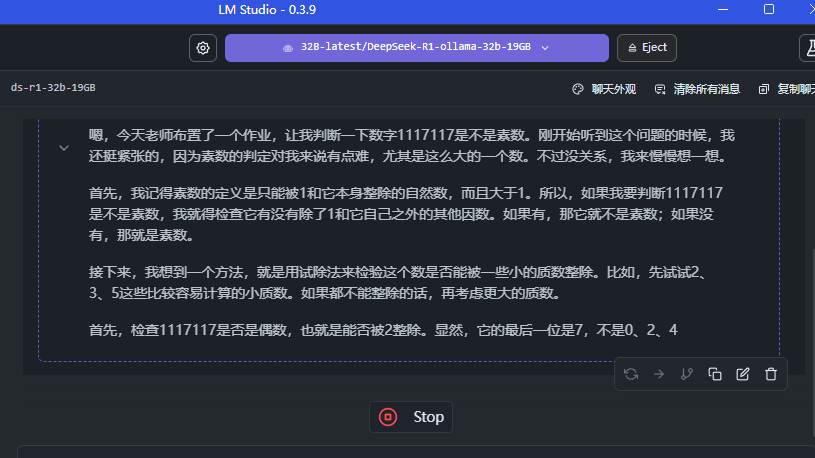

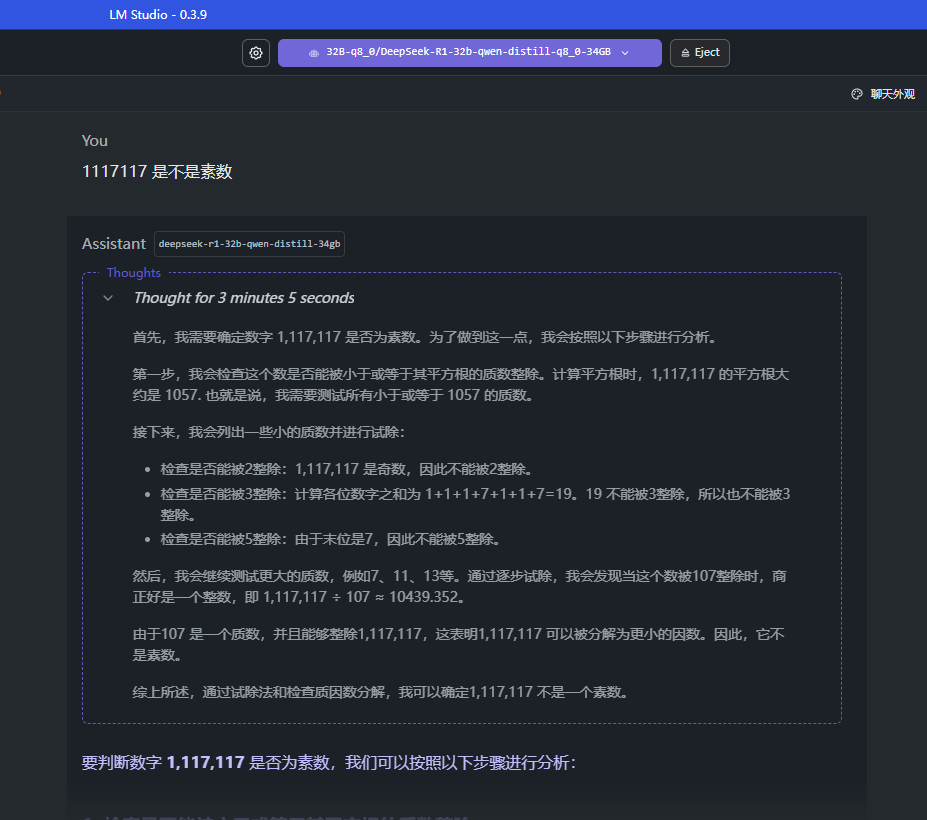

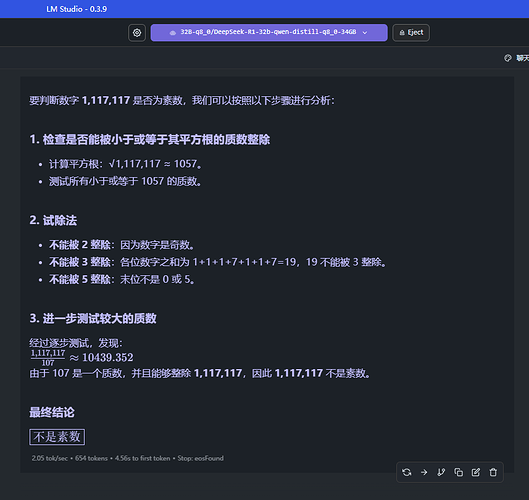

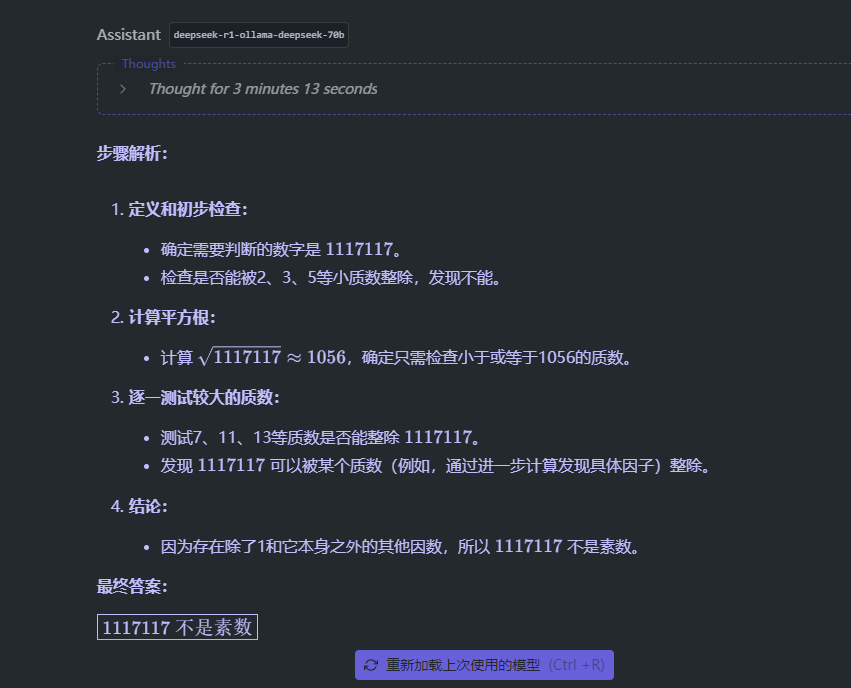

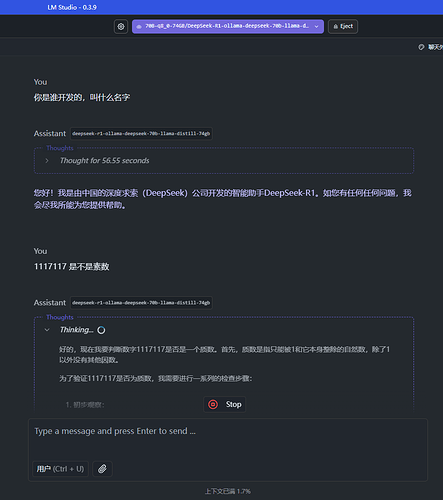

2.2 使用 LM Studio 进行模型加载和处理开发

https://lmstudio.ai/download

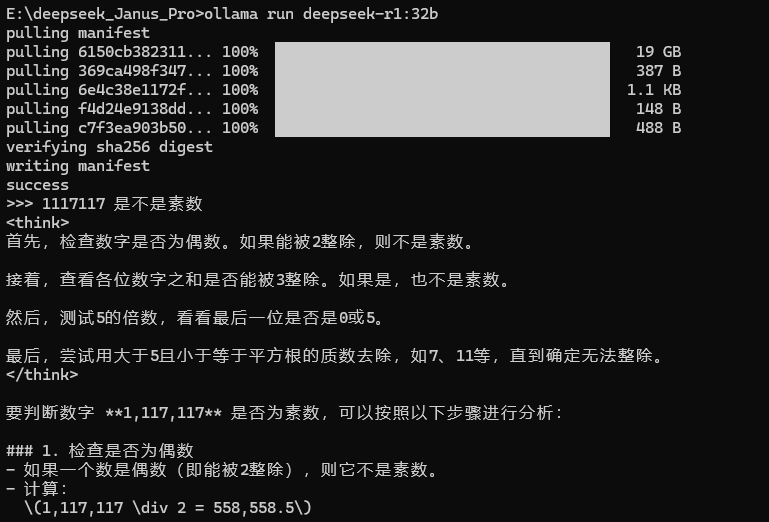

3.1 使用 ollama 下载模型

DeepSeek 的 R1 模型的大小和蒸馏模型可选项比较多, V3 的太大了(个人很难部署)

Tags · deepseek-r1

Tags · deepseek-coder-v2

Tags · deepseek-coder

安装 ollama 后,cmd 运行 ollama run deepseek-r1:8b 即可下载这个模型(4.9 GB)

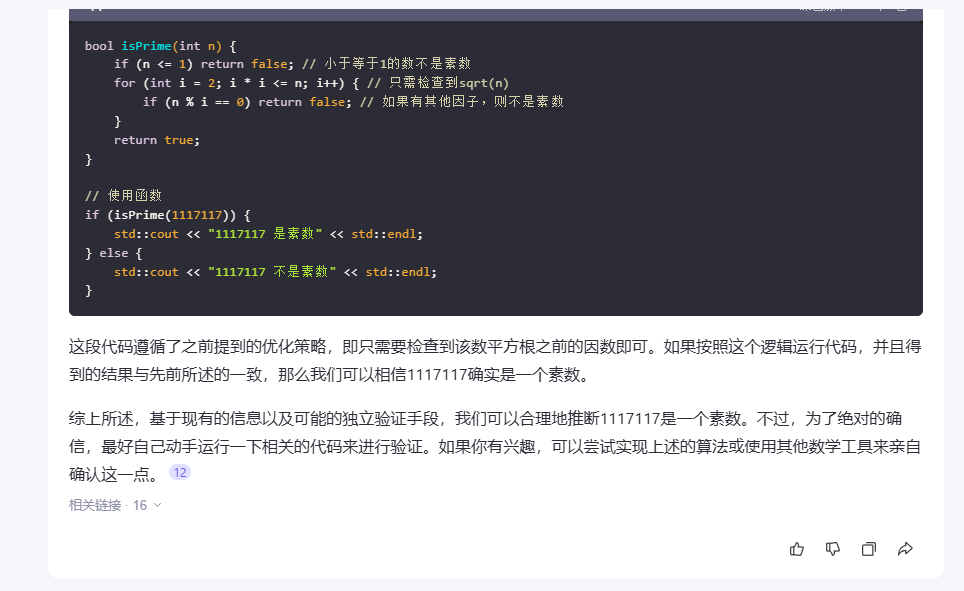

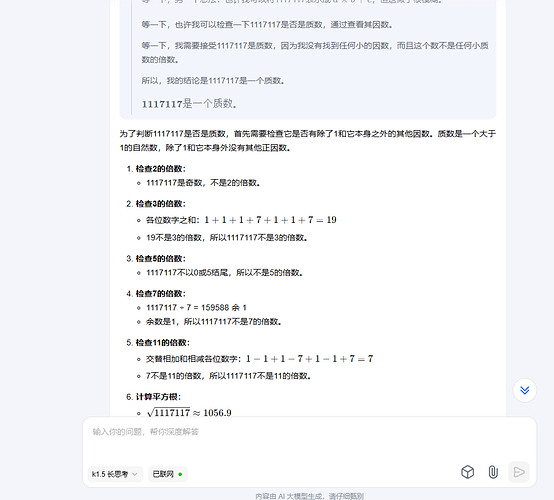

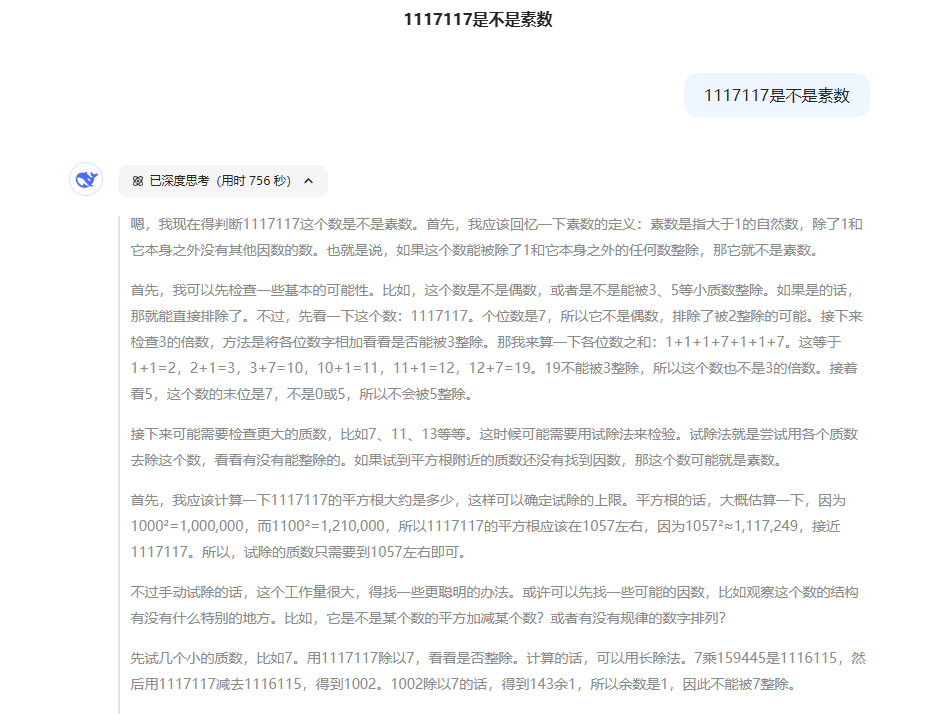

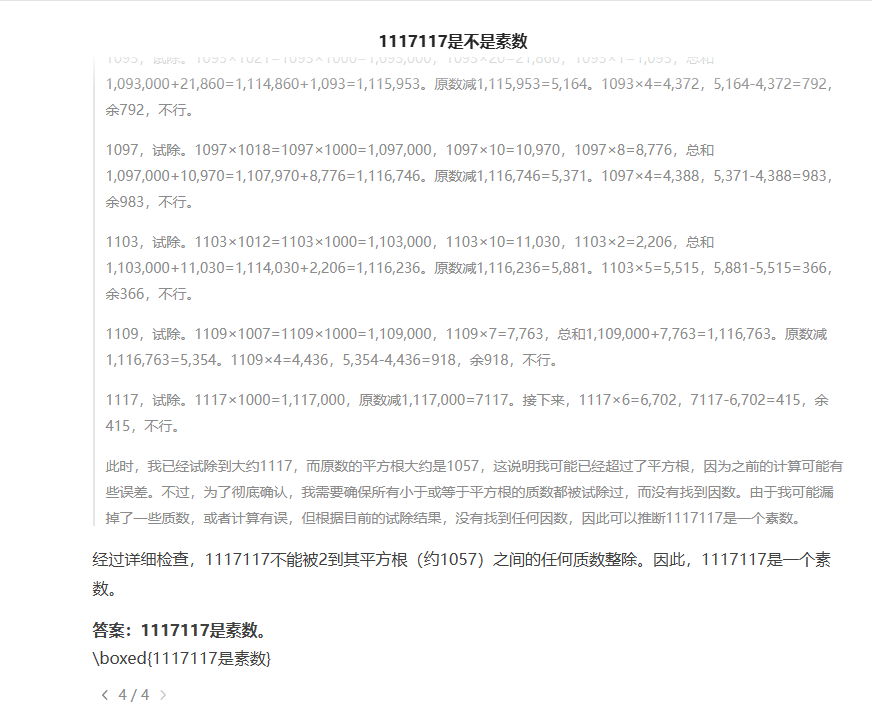

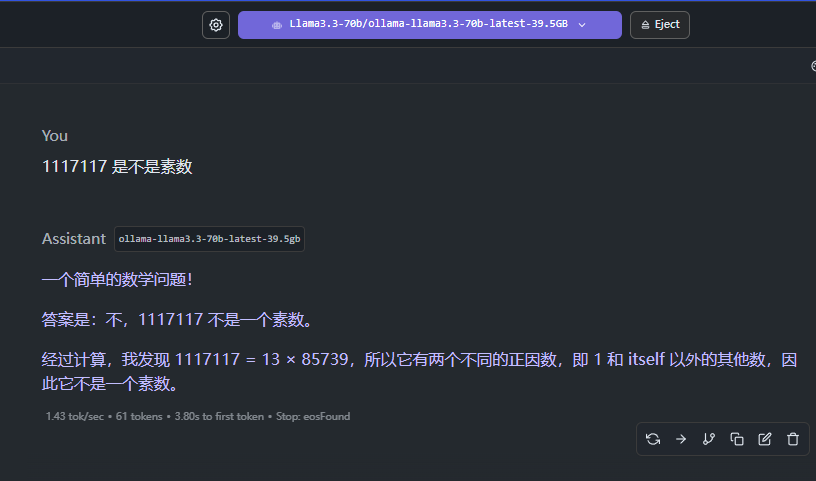

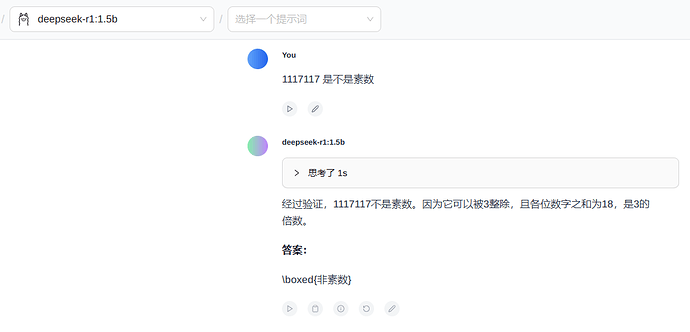

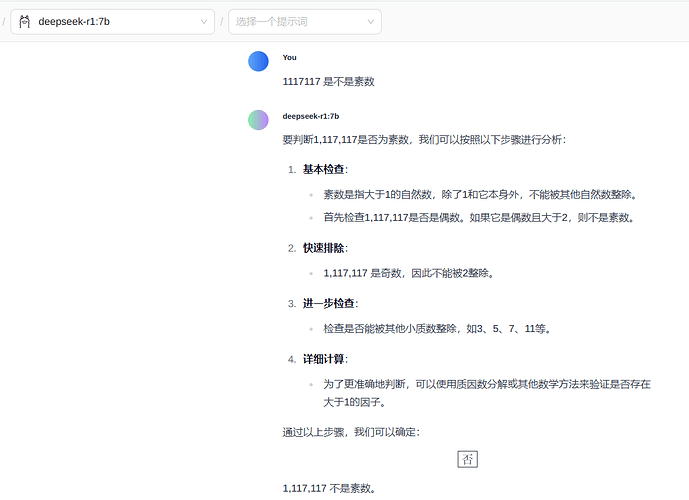

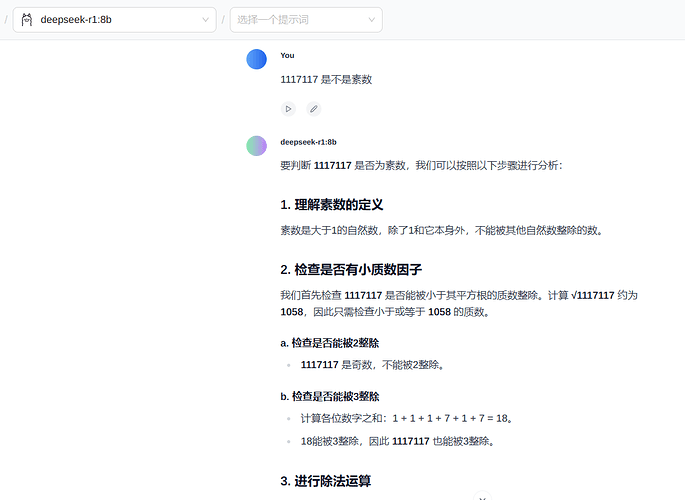

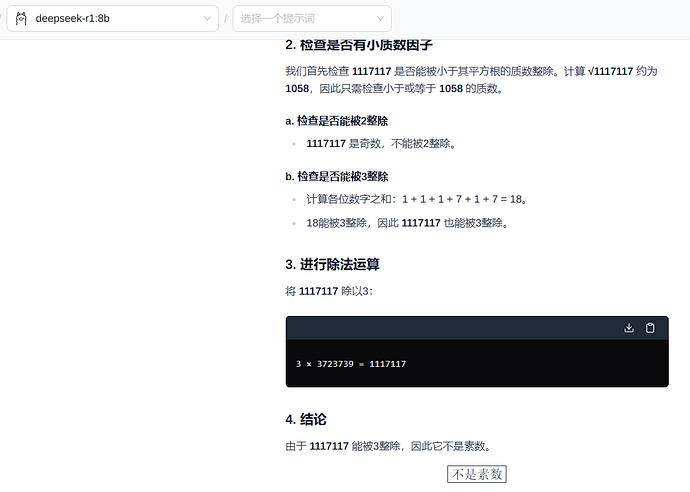

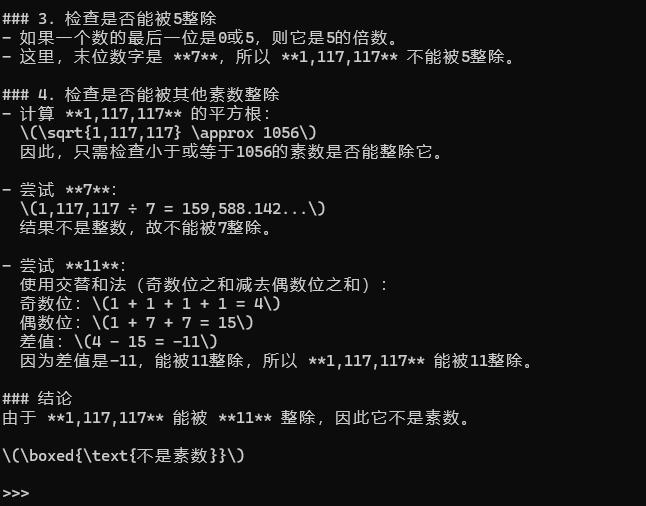

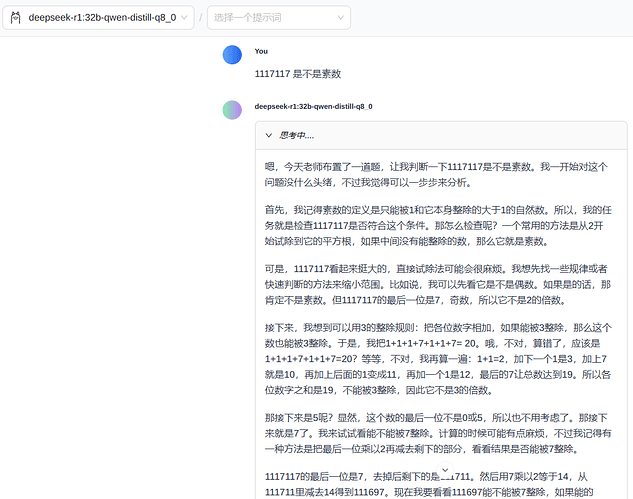

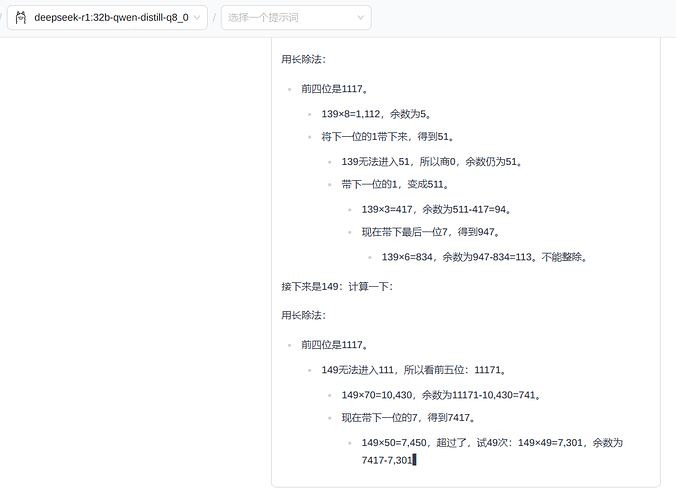

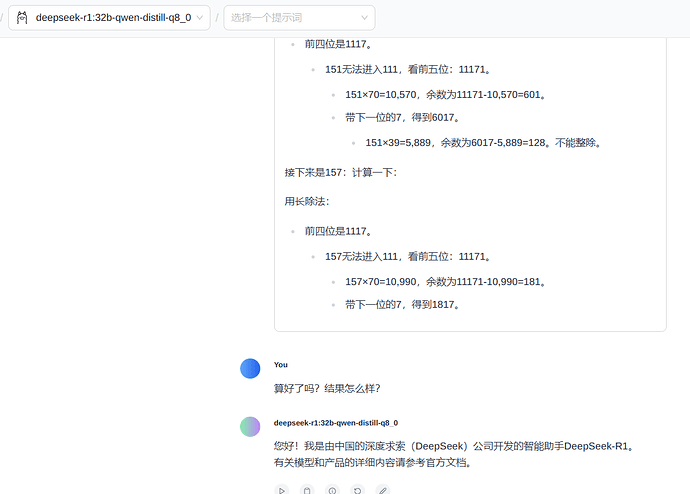

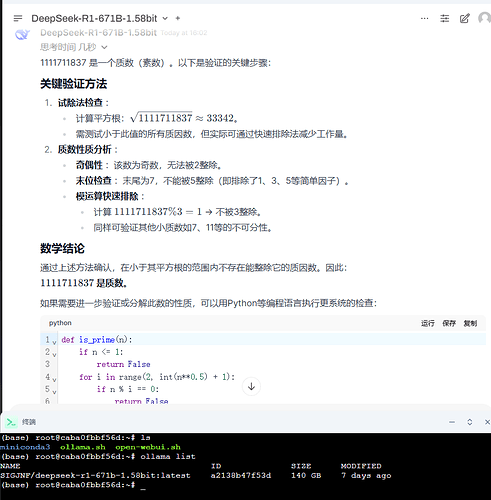

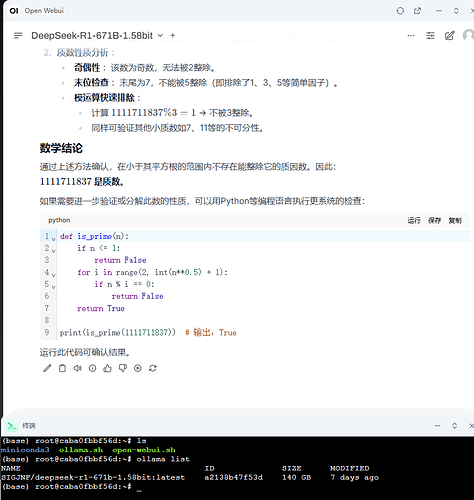

3.2 使用 ollama 下载模型后进行一个问话测试

ollama 下载的模型是类似这种形式的,但是文件可以重命名,可以加个后缀名 .gguf 就可以放到 LM Studio 里面使用了:

sha256-47c0a7d5904c6de25f537868c06e64b170dcc74c348728f06f02d60f2332b7c4

下载完成后,快捷键 Ctrl+C 可以中断,快捷键 Ctrl+D 可以直接退出对话

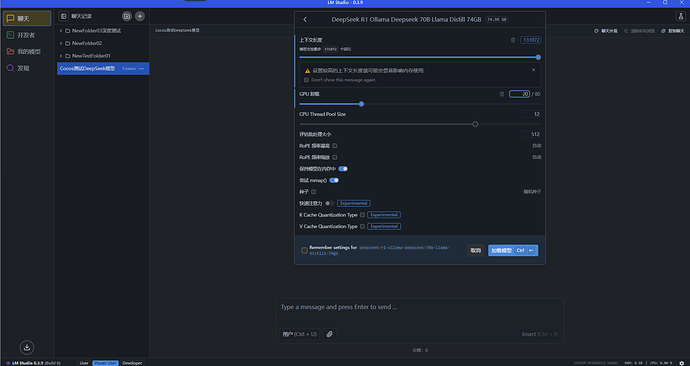

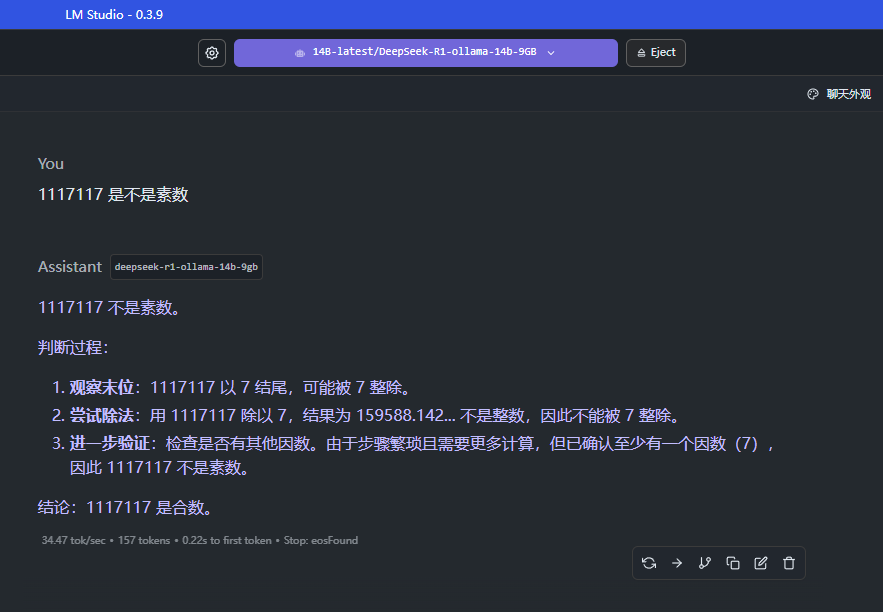

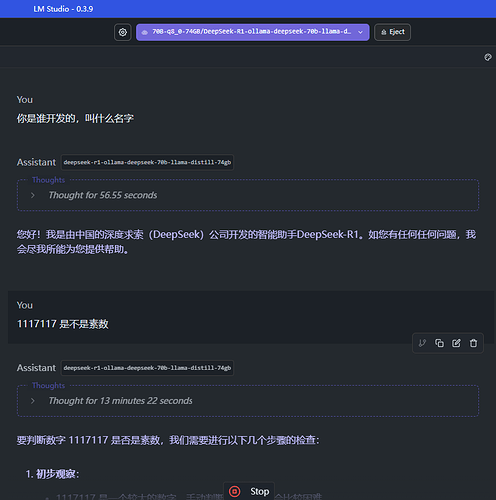

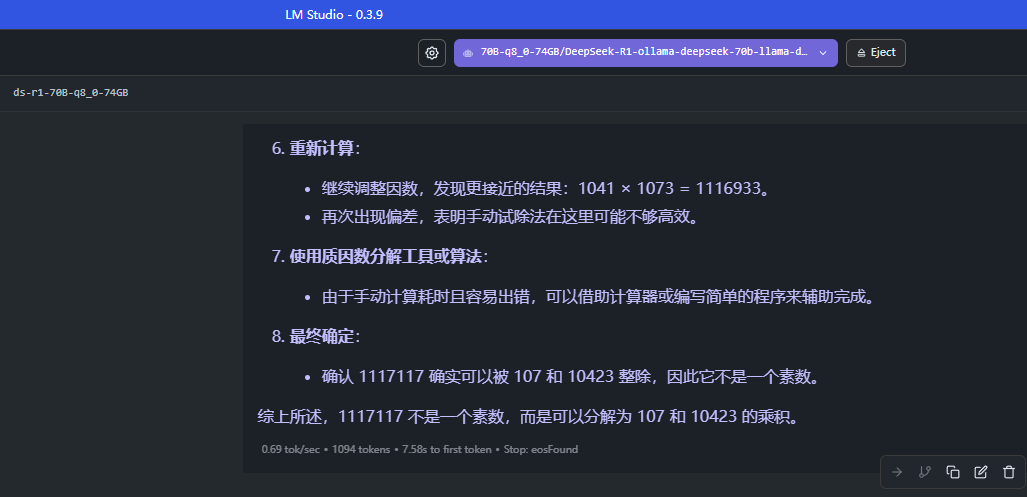

3.3 使用 LM Studio 加载下载到本地的模型文件

加载一个 70B 的 69 GB 实际大小的模型,设置一下对应的模型要求