【DeepSeek】【探索】【上】接入 DS 官方 API 部署使用多个模型

可以访问下方的链接,目前优惠中(已充值 5000 万 token),感兴趣的兄弟可以研究研究 :

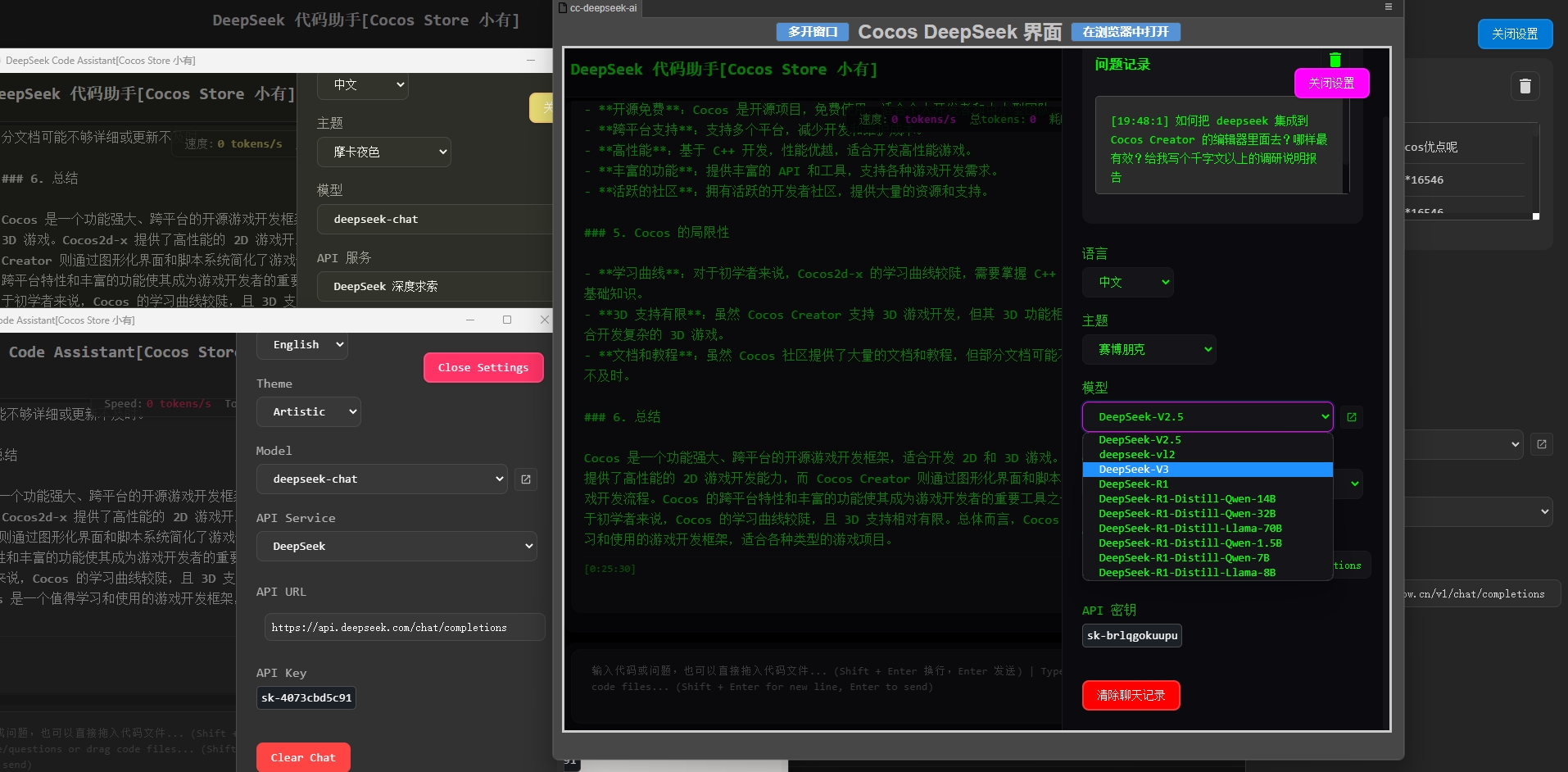

目前支持自由切换模型(包含chat和r1模型),支持自定义 api-key, 支持自定义请求地址

deepseek-reasoner

deepseek-chat

deepseek-coder

插件支持 Cocos 2.x 和 3.x 版本,插件源码未加密,内置可执行 exe 工具模型(用的chat模型)

https://store.cocos.com/app/detail/7184

Cocos \color{red}{Deepseek} 最新版本

开发环境

NodeJs 为基础

编程语言: JavaScript + Html

需要使用独享版本的 API-Key 的, 请联系我

QQ: \color{red}{386437237}

TOKEN 目前剩余的额度有 \color{red}{4000万-5000万}

目前[已测试]平台

Cocos 的版本代码仅直接运行, 跑通浏览器测试过

|Cocos Creator 3.4.0, 3.7.1, 3.8.2 | Creator 2.4.10, 2.4.9, 2.4.0, 2.4.12 | H5 |

|--------- | ---- | ----|

|  |

| |

|

|

|

Token 的含义和作用

Token的计算方式不明确,可以粗略理解为一个汉字、一个完整的单词约为2个token,一个字母、数字、符号、格式字符(空格、回车、制表符等)约为1个token。具体计算方式可以到官网自己看

功能介绍

-

写了套基于 Cocos 去调用 Deepseek 付费 API 的逻辑,目前已充值 \color{red}{5000万} token

-

所有的代码未混淆未压缩, 可以做二次开发, 结构简单, 构建逻辑比较清晰

-

兼容 Cocos 2.x 和 Cocos 3.x 版本, 可以独立启动 html 版本运行在浏览器里面

-

插件内置封装了3个的可执行文件版本

在插件目录

项目文件夹/packages/cc-deepseek-ai/panel/DeepSeek_Page

或者

项目文件夹/packages/deepseek/panel/DeepSeek_Page

里面的:

DeepseekUtilPostTest-macos

DeepseekUtilPostTest-linux

DeepseekUtilPostTest-win.exe

-

支持拖拽文件到面板上进行操作

-

支持清除聊天记录,清除和查看问题记录

-

支持自动记录上下文信息(默认的Deepseek的传输是不记录上下文的,需要自行传递)

讨论&交流

使用教程

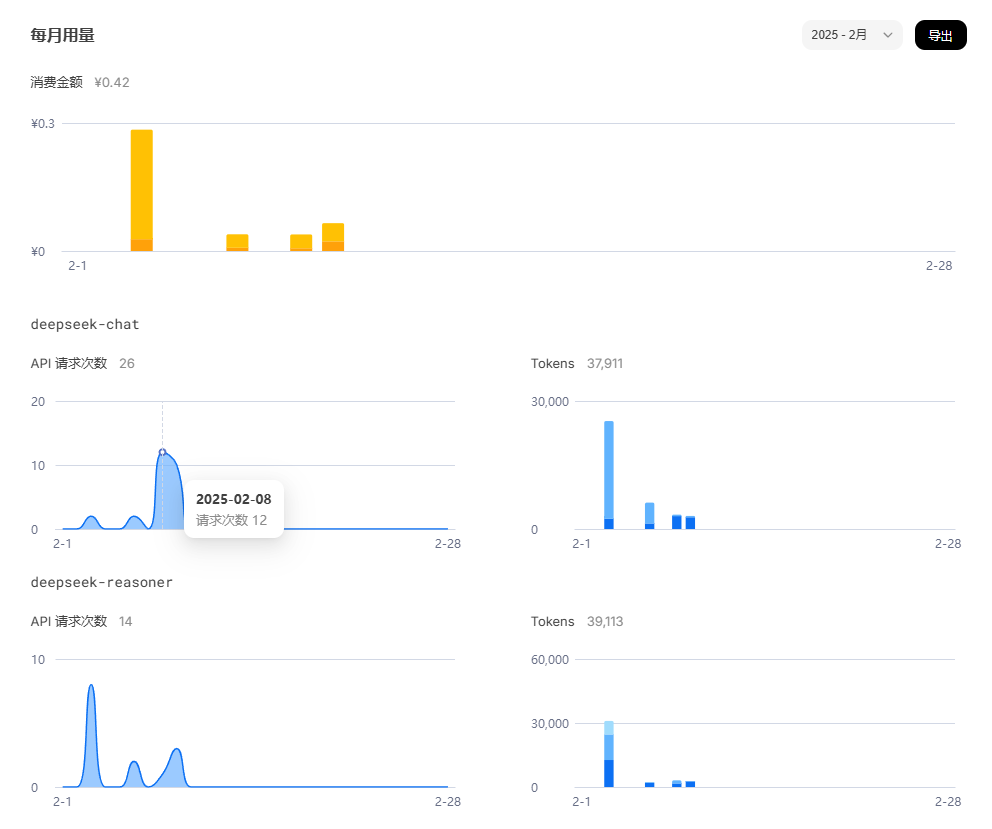

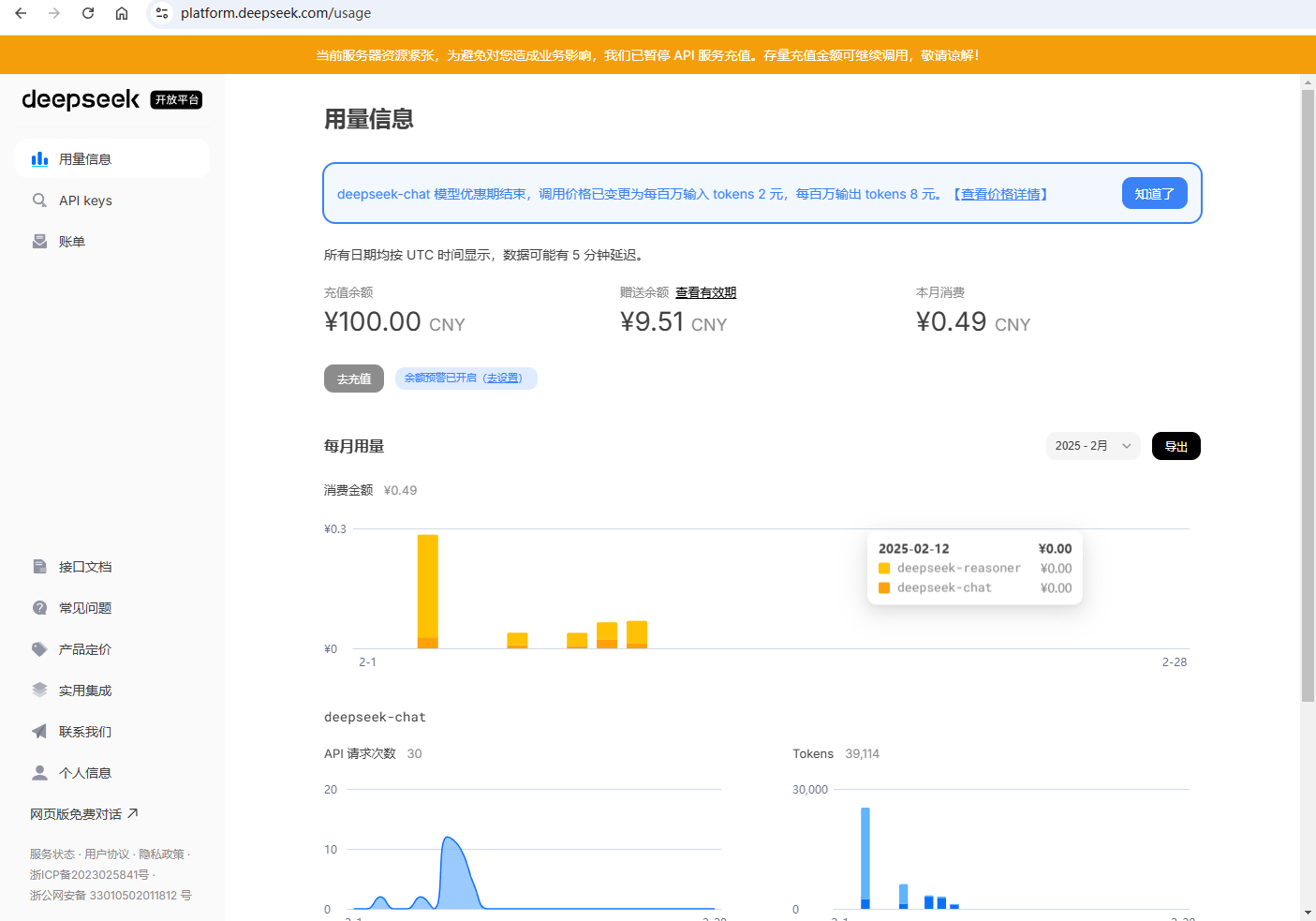

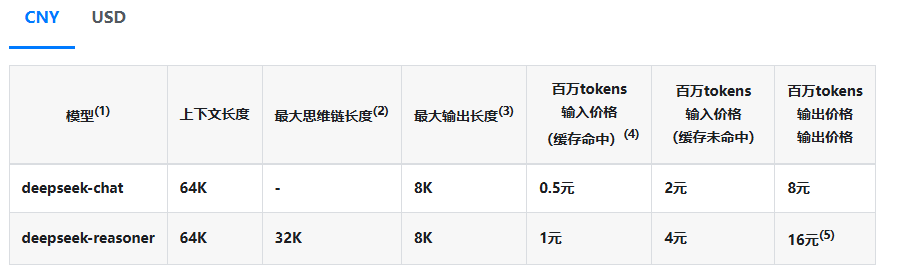

1.0.1 这是 Deepseek 官方的用量介绍

也可以自行去官网创造自己的 api-keys:

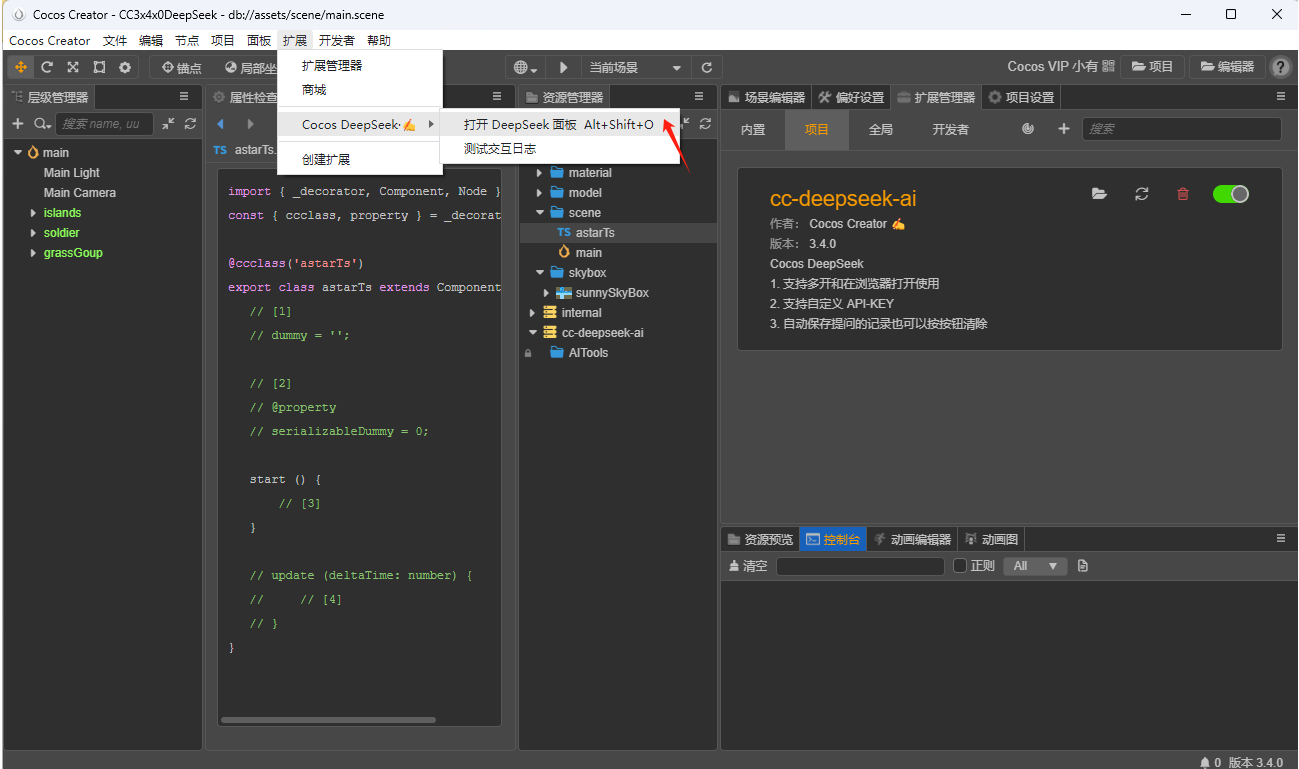

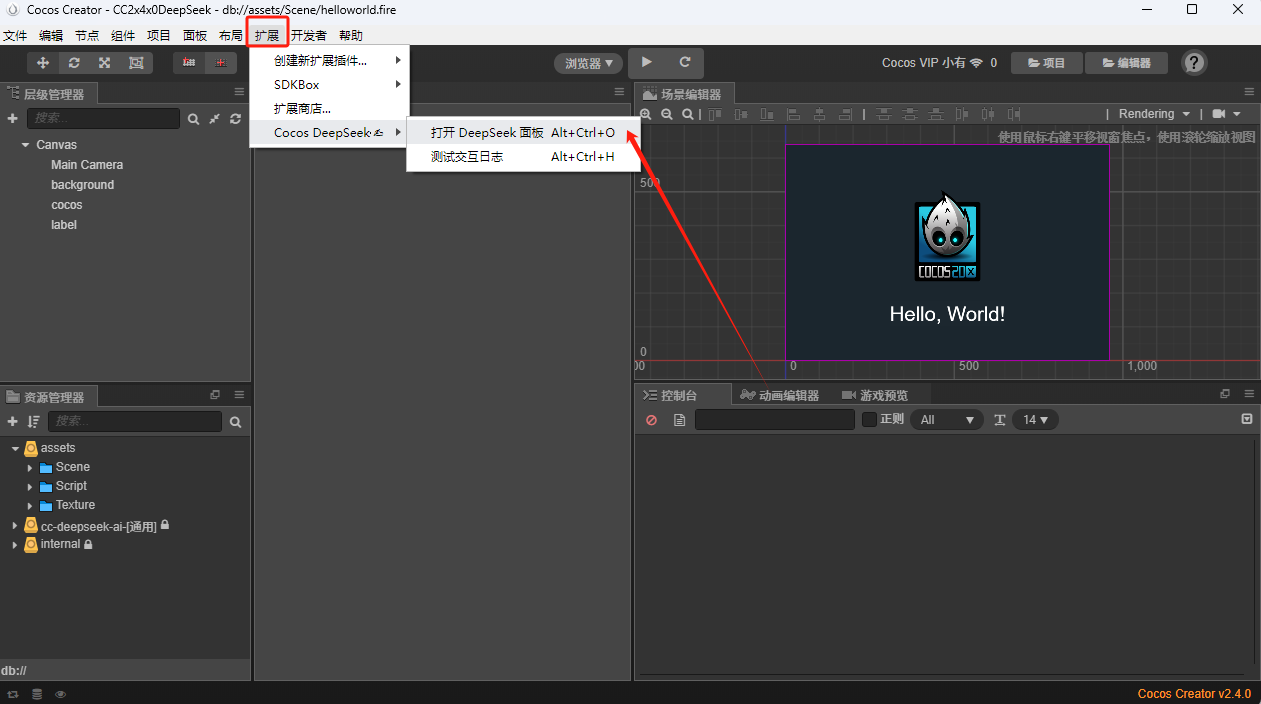

1.1 打开 Cocos Deepseek 面板, 简单查看下, 支持快捷键操作

1.1.2 从菜单打开编程面板也可以快捷键打开

1.2 简单拖拽下文件看看

1.3 简单让 Deepseek 写个新代码逻辑

2.1 多开和浏览器打开使用

2.2 使用exe等可执行文件提问

关于 Deepseek , 小白基础知识概要

DeepSeek-V3 的综合能力

DeepSeek-V3 在推理速度上相较历史模型有了大幅提升。

在目前大模型主流榜单中,DeepSeek-V3 在开源模型中位列榜首,与世界上最先进的闭源模型不分伯仲。

插件源码目录

插件 ZIP 文件大小:

43.3 MB (45,490,940 字节)

cc-deepseek-ai

├─i18n

├─node_modules

├─panel

│ └─DeepSeek_Page

└─run_times

└─AITools

更新声明

- 后续更新的版本会继续放在这里面更新

版权声明

-

该插件资源中的源代码可商业使用

-

商业授权范围仅限于在您自行开发的游戏作品中使用

-

不得进行任何形式的转售、租赁、传播等

联系作者

-

QQ : 386437237

-

邮箱 : 386437237@qq.com

-

交流群

购买须知

-

请各位朋友看后仔细思考,是否符合您的项目或者研究需求,谨慎使用

-

目前内容相对比较少, 后续才会迭代

-

因为本产品为付费虚拟商品,一经购买成功概不退款,请在购买谨慎确认购买内容。

随着不断填充数据,这个自动化基本上都是迟早的事情了。

随着不断填充数据,这个自动化基本上都是迟早的事情了。

新一代智能开发解决方案

新一代智能开发解决方案 技术架构

技术架构 需要企业级独享 API 密钥?或者商务合作?或者本地部署 Deepseek Rag ?立即联系技术顾问

需要企业级独享 API 密钥?或者商务合作?或者本地部署 Deepseek Rag ?立即联系技术顾问 QQ: 386437237 &

QQ: 386437237 &  当前共享池剩余Token:4500万+(不定时补充)

当前共享池剩余Token:4500万+(不定时补充) 全平台兼容矩阵

全平台兼容矩阵 Token 的含义和作用

Token 的含义和作用 功能介绍

功能介绍