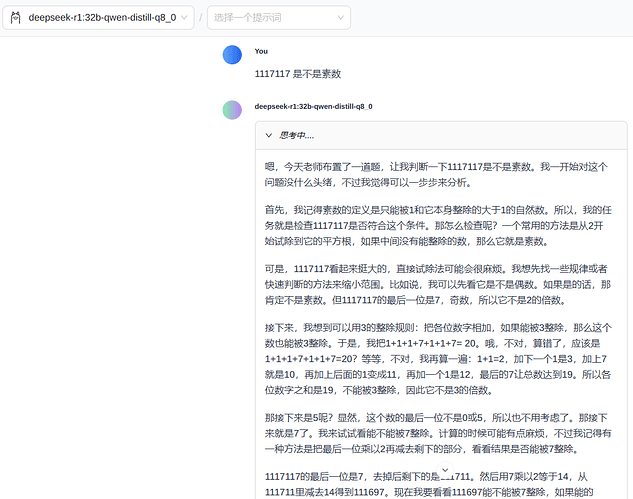

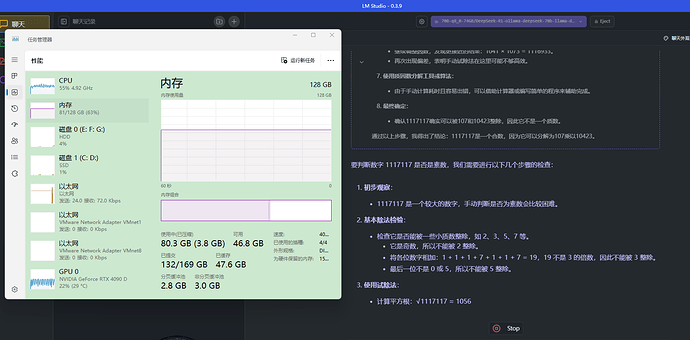

结论:整体来说对显卡的运算的要求不怎么高

甚至我后台挂了个 comfyUI 在运行,基本上也还行

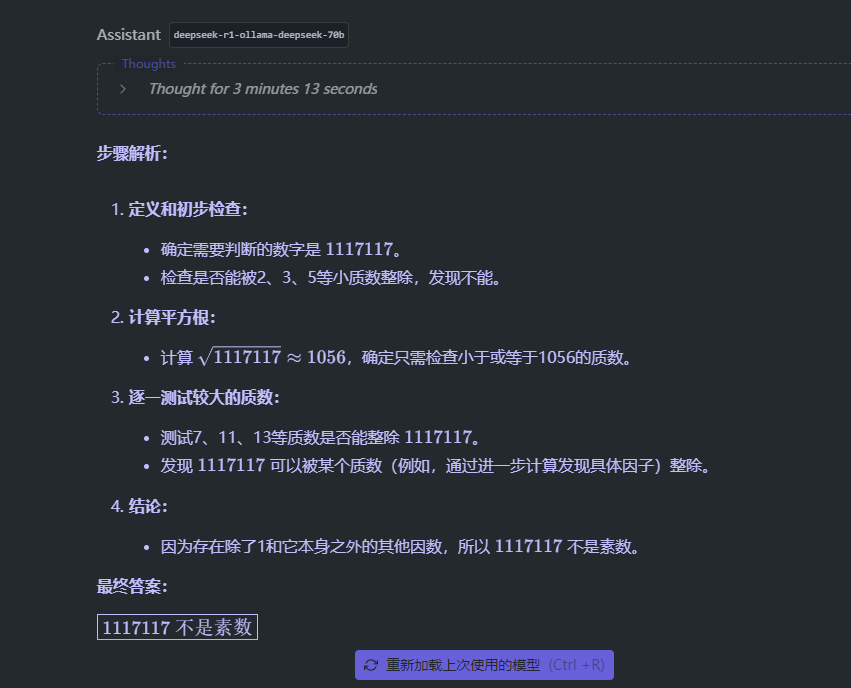

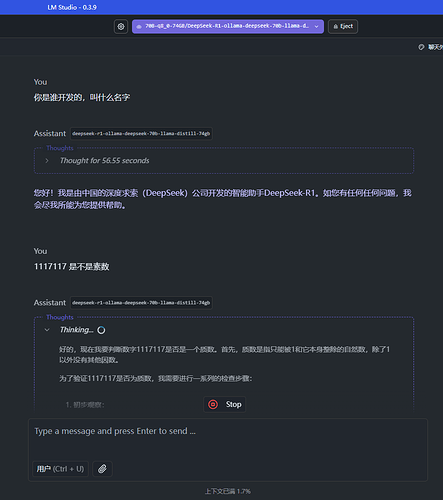

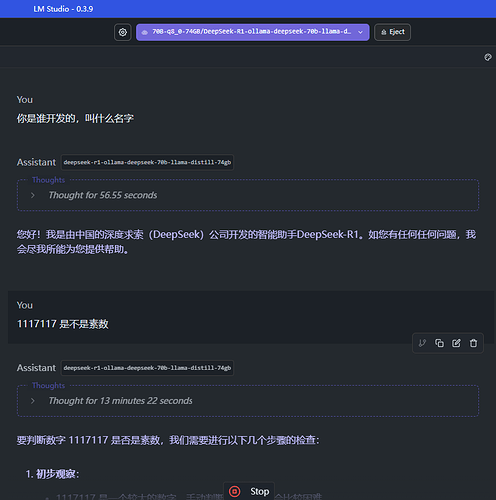

缺点:

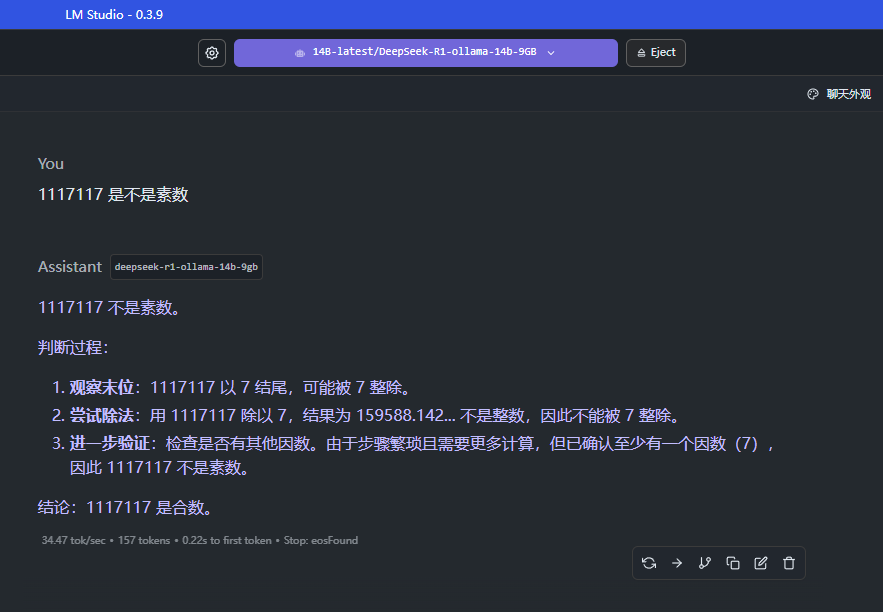

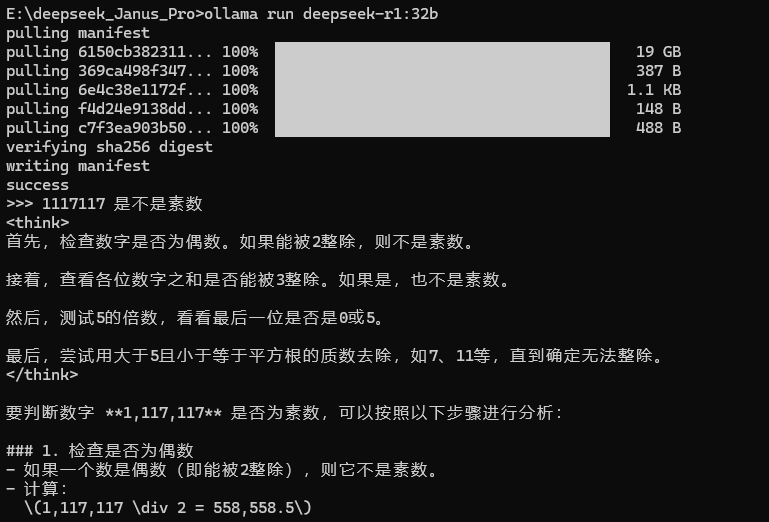

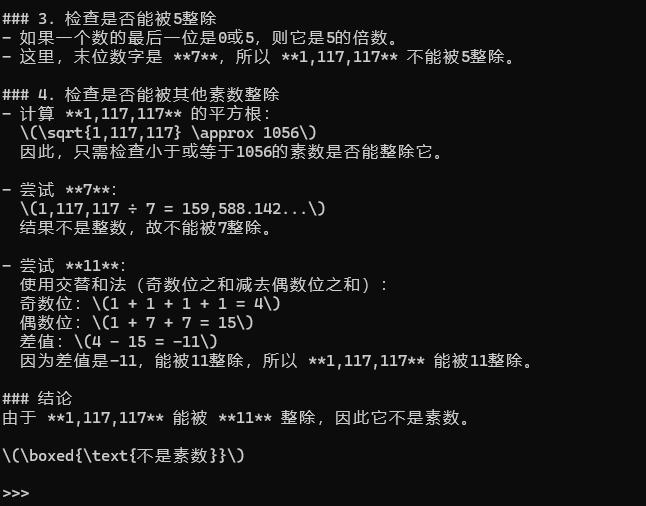

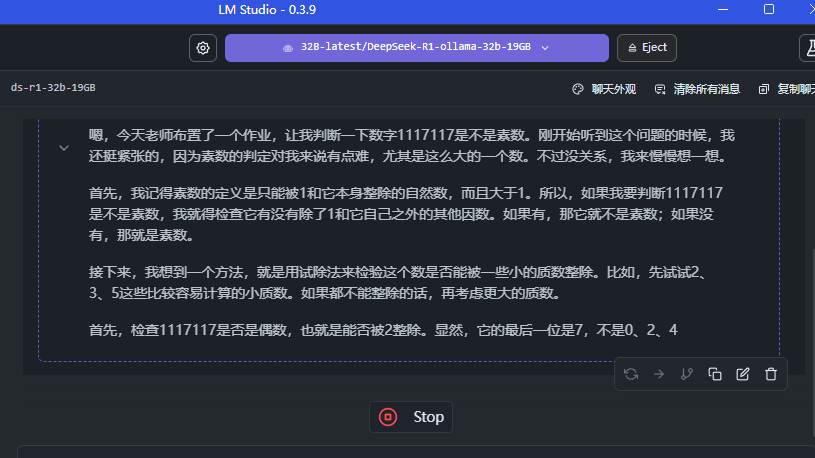

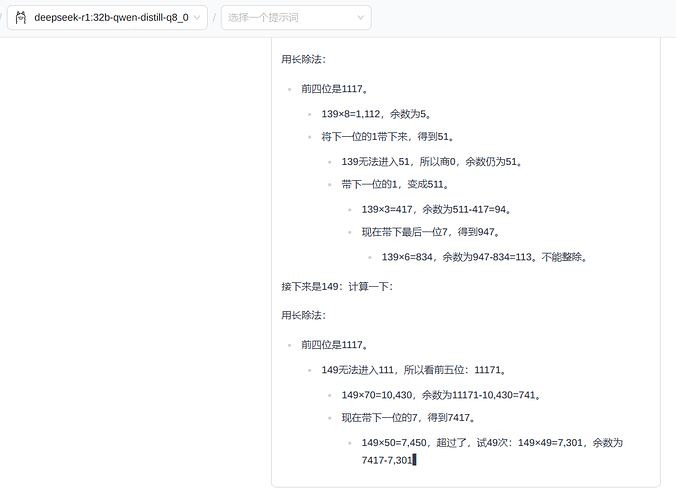

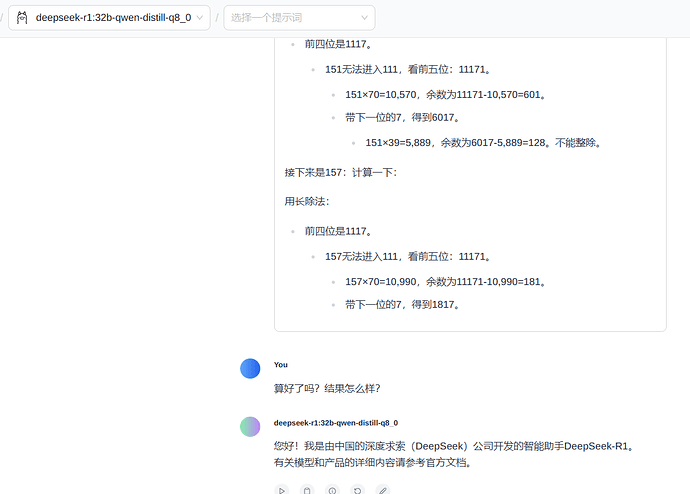

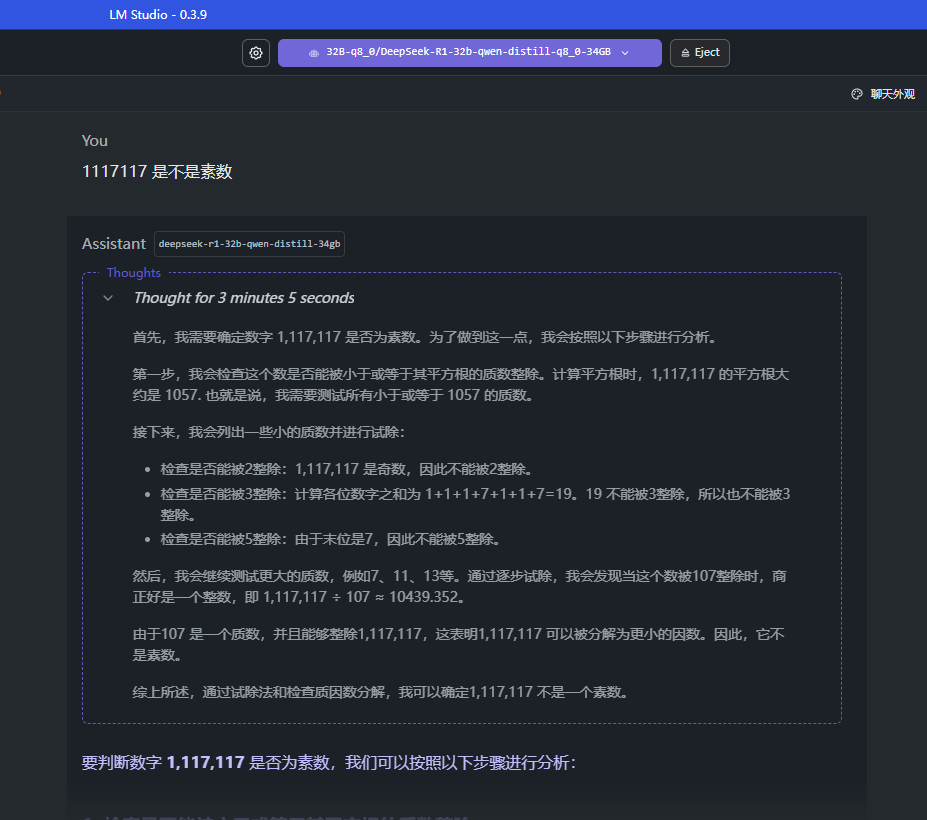

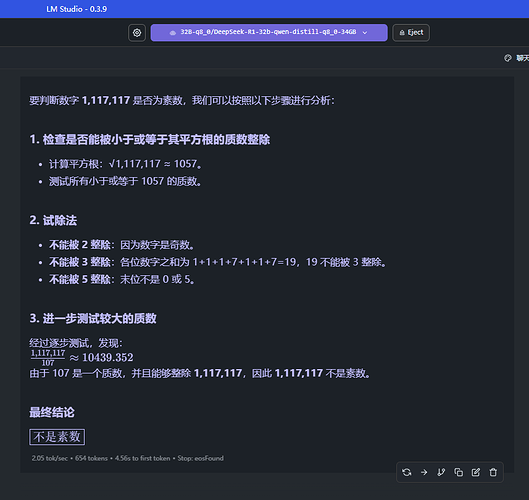

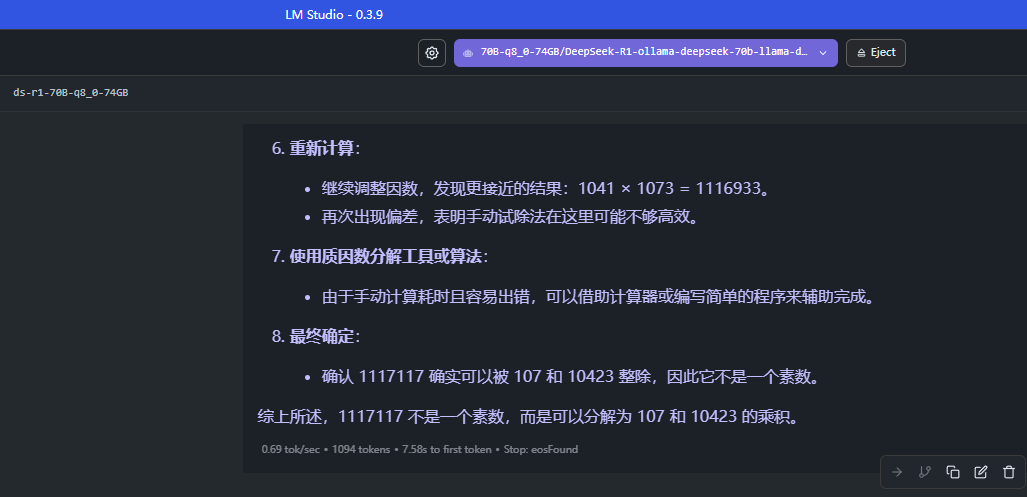

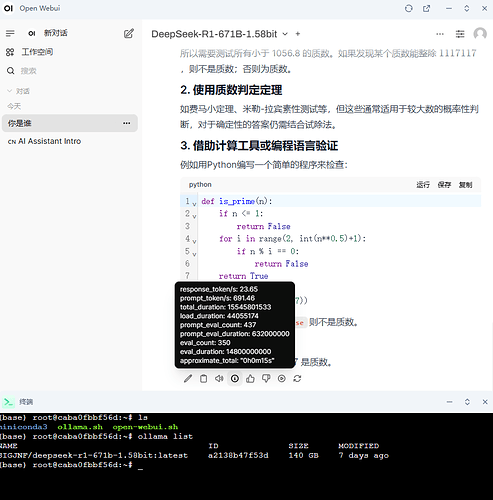

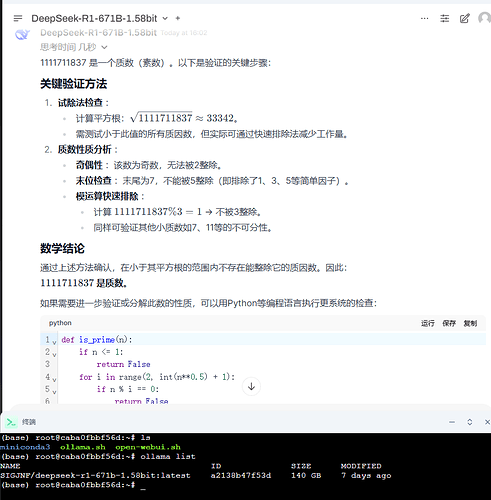

这个 69.83 GB 的本地 Deepseek 的模型,虽然我的 128 GB 的内存条还算OK,但是压力很大,运行起来感觉很吃力,有时候会运算到占用 115GB 内存的情况,对显卡倒是没太大要求,然后这个运行起来,很慢,出的回答,基本上就是每秒 5~15 个字左右。

综上所述:

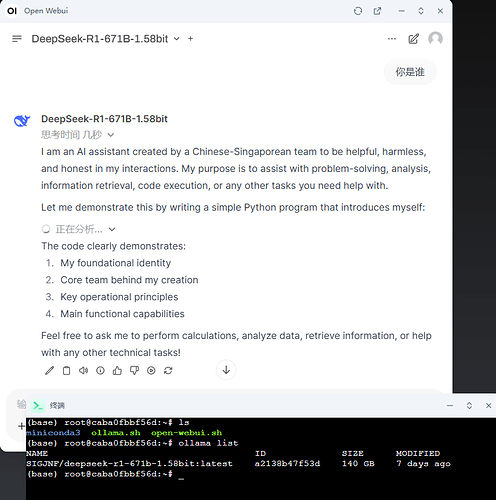

如果运行的是 20 GB 左右的模型,基本上回复就比较快,感觉比较流畅,30GB 的也可以,所以如果对思考的算力和逻辑要求不高的兄弟,可以考虑部署一个 1/4 左右内存条的模型:

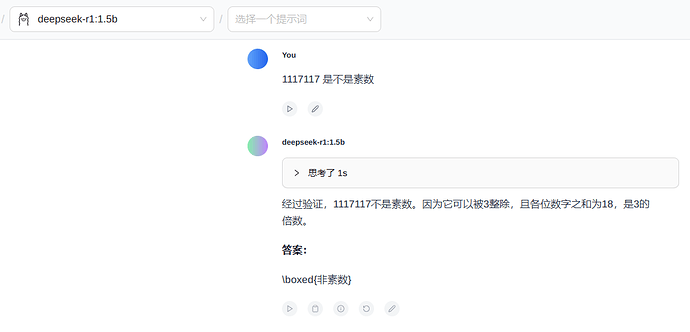

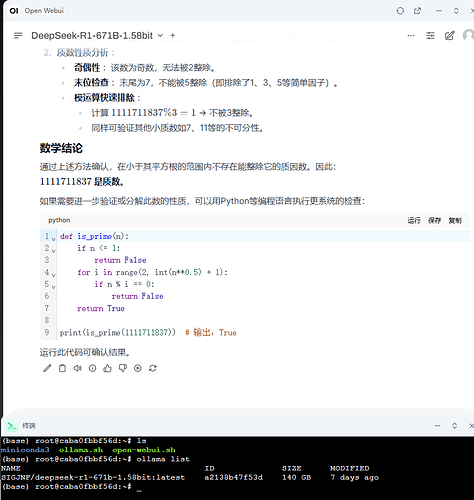

比如说 16 GB 的内存条,可以部署默认的 Deepseek R1 1.5b 模型(1.1 GB ),运行起来还是很流畅的。